本文共 3357 字,大约阅读时间需要 11 分钟。

这个实现可以为BERT加载任何预训练的TensorFlow checkpoint(特别是谷歌的官方预训练模型),并提供一个转换脚本。

BERT-base和BERT-large模型的参数数量分别为110M和340M,为了获得良好的性能,很难使用推荐的batch size在单个GPU上对其进行微调。为了帮助微调模型,这个repo还提供了3种可以在微调脚本中激活技术:梯度累积(gradient-accumulation)、 multi-GPU 和分布式训练。

其结果如下:

● 在序列级MRPC分类任务上,该实现使用小型BERT-base模型再现了原始实现的84%-88%的准确率。 ● 在token级的SQuAD 任务上,该个实现使用小型BERT-base模型再现了原始实现的88.52 F1的结果。作者表示,正致力于在其他任务以及更大的BERT模型上重现结果。

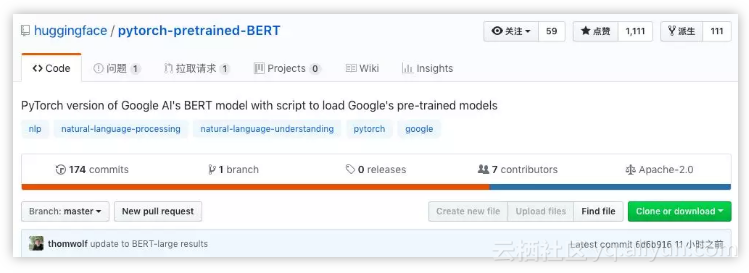

BERT模型的PyTorch实现

这个存储库包含了谷歌BERT模型的官方TensorFlow存储库的op-for-op PyTorch重新实现。谷歌的官方存储库是与一起发布的:BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding,作者是Jacob Devlin、Ming-Wei Chang、Kenton Lee和Kristina Toutanova。

这个实现可以为BERT加载任何预训练的TensorFlow checkpoint(特别是谷歌的预训练模型),并提供了一个转换脚本(见下文)。

此外,我们将在本周晚些时候添加多语言版本和中文版本的模型代码。

脚本:加载任何TensorFlow检查点

使用convert_tf_checkpoint_to_pytorch.py脚本,你可以在PyTorch保存文件中转换BERT的任何TensorFlow检查点(尤其是谷歌发布的官方预训练模型)。

这个脚本将TensorFlow checkpoint(以bert_model.ckpt开头的三个文件)和相关的配置文件(bert_config.json)作为输入,并为此配置创建PyTorch模型,从PyTorch模型的TensorFlow checkpoint加载权重并保存生成的模型在一个标准PyTorch保存文件中,可以使用 torch.load() 导入(请参阅extract_features.py,run_classifier.py和run_squad.py中的示例)。

只需要运行一次这个转换脚本,就可以得到一个PyTorch模型。然后,你可以忽略TensorFlow checkpoint(以bert_model.ckpt开头的三个文件),但是一定要保留配置文件(bert_config.json)和词汇表文件(vocab.txt),因为PyTorch模型也需要这些文件。

要运行这个特定的转换脚本,你需要安装TensorFlow和PyTorch。该库的其余部分只需要PyTorch。

下面是一个预训练的BERT-Base Uncased 模型的转换过程示例:

export BERT_BASE_DIR=/path/to/bert/uncased_L-12_H-768_A-12python convert_tf_checkpoint_to_pytorch.py --tf_checkpoint_path $BERT_BASE_DIR/bert_model.ckpt --bert_config_file $BERT_BASE_DIR/bert_config.json --pytorch_dump_path $BERT_BASE_DIR/pytorch_model.bin

你可以在这里下载Google的预训练转换模型:

https://github.com/google-research/bert#pre-trained-models

BERT的PyTorch模型

在这个库里,我们提供了三个PyTorch模型,你可以在modeling.py中找到:

● BertModel - 基本的BERT Transformer 模型 ● BertForSequenceClassification - 顶部带有sequence classification head的BERT模型 ● BertForQuestionAnswering - 顶部带有token classification head 的BERT模型,以下是每类模型的一些细节。

1 . BertModel

BertModel是一个基本的BERT Transformer模型,包含一个summed token、位置和序列嵌入层,然后是一系列相同的self-attention blocks(BERT-base是12个blocks, BERT-large是24个blocks)。

输入和输出与TensorFlow 模型的输入和输出相同。

具体来说,该模型的输入是:

● input_ids: 一个形状为[batch_size, sequence_length]的torch.LongTensor,在词汇表中包含单词的token索引 ● token_type_ids: 形状[batch_size, sequence_length]的可选torch.LongTensor,在[0,1]中选择token类型索引。类型0对应于句子A,类型1对应于句子B。 ● attention_mask: 一个可选的torch.LongTensor,形状为[batch_size, sequence_length],索引在[0,1]中选择。模型的输出是由以下内容组成的一个元组:

● all_encoder_layers: 一个大小为[batch_size, sequence_length,hidden_size]的torch.FloatTensor列表,它是每个注意块末端隐藏状态的完整序列列表(即BERT-base的12个完整序列,BERT-large的24个完整序列) ● pooled_output :一个大小为[batch_size, hidden_size]的torch.FloatTensor,它是在与输入(CLF)的第一个字符相关联的隐藏状态之上预训练的分类器的输出,用于训练Next-Sentence任务(参见BERT的论文)。extract_features.py脚本提供了有关如何使用这类模型的示例,该脚本可用于为给定输入提取模型的隐藏状态。

2 . BertForSequenceClassification

BertForSequenceClassification是一个fine-tuning 模型,包括BertModel,以及BertModel顶部的一个序列级分类器(sequence-level classifier)。

序列级分类器是一个线性层,它将输入序列中第一个字符的最后隐藏状态作为输入(参见BERT论文中的图3a和3b)。

run_classifier.py脚本提供了关于如何使用此类模型的示例,该脚本可用于使用BERT微调单个序列(或序列对)分类器,例如用于MRPC任务。

3. BertForQuestionAnswering

BertForQuestionAnswering是一个fine-tuning 模型,包括BertModel,它在最后隐藏状态的完整序列之上具有token级分类器(token-level classifiers)。

token-level 分类器将最后隐藏状态的完整序列作为输入,并为每个token计算得分,(参见BERT论文的图3c和3d)。

run_squad.py脚本提供了有关如何使用此类模型的示例,该脚本可用于使用BERT微调token分类器,例如用于SQuAD任务。

原文发布时间为:2018-11-13

本文作者:huggingface

本文来自云栖社区合作伙伴“”,了解相关信息可以关注“”。

转载地址:http://vvpja.baihongyu.com/